🔑 Les points clés à retenir sur l’Intelligence Artificielle :

Machine Learning : Le Machine Learning est une sous-discipline de l’IA qui consiste à entraîner des algorithmes à apprendre à partir de données pour effectuer des tâches spécifiques.

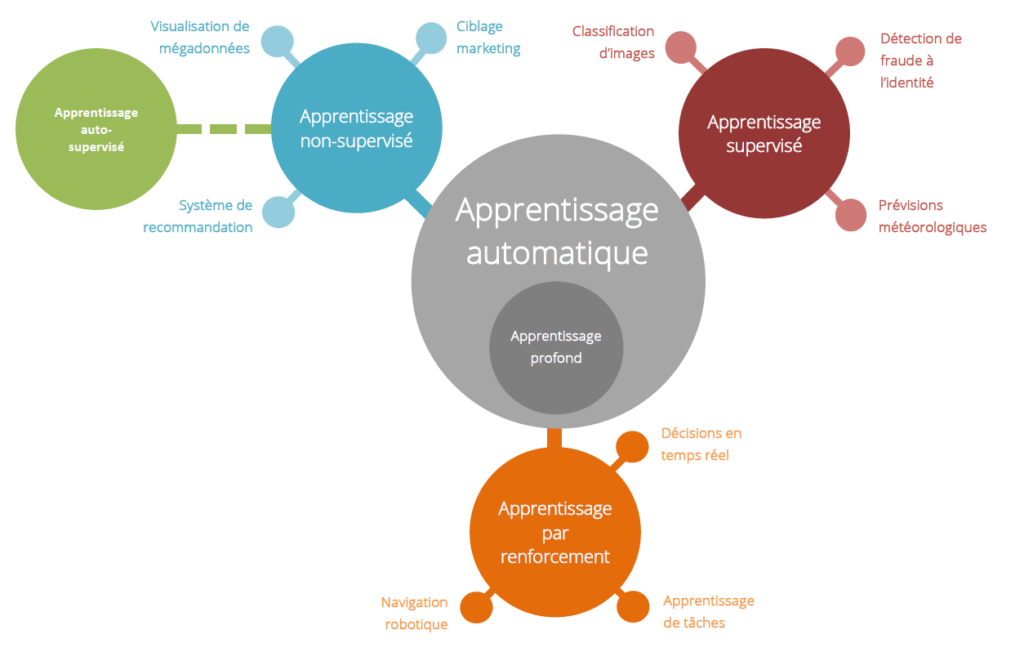

Apprentissage Automatique : L’apprentissage automatique est une technique clé de l’IA qui permet aux systèmes d’apprendre à partir de données et d’améliorer leurs performances avec l’expérience.

Données : Les données sont essentielles pour l’IA. Les systèmes d’IA dépendent de l’acquisition, du nettoyage et de l’analyse de grandes quantités de données pour fonctionner efficacement.

Le Deep Learning : Le Deep Learning est une sous-discipline du machine learning qui repose sur l’utilisation de réseaux de neurones artificiels profonds pour résoudre des tâches complexes.

Applications de l’IA : L’IA est utilisée dans divers domaines, notamment la vision par ordinateur, le traitement du langage naturel, la robotique, la santé, les transports, la finance, la cybersécurité, la gestion de la chaîne d’approvisionnement, et bien d’autres.

Avancées récentes : L’IA a connu des avancées significatives grâce à des techniques telles que le Deep Learning et l’augmentation de la puissance de calcul. Ces progrès ont permis des applications innovantes, telles que la reconnaissance faciale, la traduction automatique, et les véhicules autonomes.

L’Intelligence Artificielle et la 3D : Ils forment une combinaison puissante qui ouvre de nouvelles perspectives dans de nombreux domaines, de la création artistique à la recherche scientifique en passant par l’industrie et la médecine.

Comment définir l'Intelligence Artificielle - IA

L’IA est à la fois un champ de recherche scientifique et une source de réflexion philosophique et éthique.

Elle soulève des questions profondes sur la nature de l’intelligence, de la conscience, de la créativité, de la morale et de la relation entre l’homme et la machine.

L’IA est un champ interdisciplinaire qui puise des connaissances et des méthodes de diverses disciplines pour atteindre ses objectifs, qu’il s’agisse de créer des systèmes intelligents, de comprendre la cognition, de répondre à des défis éthiques ou de réguler son utilisation.

L’intelligence artificielle (IA) est un domaine de l’informatique qui se concentre sur la création de systèmes informatiques capables d’accomplir des tâches qui nécessitent généralement l’intelligence humaine.

Cela inclut des activités telles que la compréhension du langage naturel, la résolution de problèmes, l’apprentissage, la perception visuelle, la reconnaissance de motifs, et bien d’autres. L’objectif de l’IA est de développer des programmes informatiques et des systèmes qui peuvent imiter, voire surpasser, la capacité humaine à prendre des décisions, apprendre à partir de l’expérience et s’adapter à de nouvelles situations.

L’IA englobe un large éventail de techniques et de méthodes, notamment l’apprentissage automatique (machine learning), les réseaux de neurones artificiels, le traitement du langage naturel (NLP), la vision par ordinateur, la robotique, …

🧐 Intéressons nous plus spécifiquement à une Discipline qui a fait franchir un nouveau cap à l’IA, le « Machine Learning »

Le Machine Learning, un sous domaine de l'Intelligence Artificielle - IA

Le Machine Learning est une science moderne permettant de découvrir des répétitions (des patterns) dans un ou plusieurs flux de données et d’en tirer des prédictions en se basant sur des statistiques. En clair, le Machine Learning se base sur le forage de données, permettant la reconnaissance de « patterns » pour fournir des analyses prédictives.

Les premiers algorithmes de Machine Learning ne datent pas d’hier, puisque certains ont été conçus dès 1950, le plus connu d’entre eux étant le Perceptron.

Le Machine Learning révèle tout son potentiel dans les situations où des insights (tendances) doivent être repérés à partir de vastes ensembles de données diverses et variées, appelés le Big Data.

Pour analyser de tels volumes de données, le Machine Learning se révèle bien plus efficace en termes de vitesse et de précisions que les autres méthodologies traditionnelles. À titre d’exemple, le Machine Learning est capable de déceler une fraude en une milliseconde, rien qu’en se basant sur des données issues d’une transaction (montant, localisation…), ainsi que sur d’autres informations historiques et sociales qui lui sont rattachées. En ce qui concerne l’analyse de données transactionnelles, de données issues de plateformes CRM ou bien des réseaux sociaux, là encore le Machine Learning se révèle désormais indispensable.

Le Machine Learning est réellement la science idéale pour tirer profit du Big Data et de ses opportunités. Cette technologie est en effet capable d’extraire les données de valeur parmi d’immenses sources d’informations complexes, et ce sans avoir à faire appel aux humains. Entièrement dirigé par les données, le Machine Learning convient donc parfaitement à la complexité du Big Data, dont il est réellement indissociable. Là où les outils analytiques traditionnels se heurtent bien souvent à un volume maximal de données pouvant être analysées, le Machine Learning révèle au contraire tout son potentiel lorsque les sources de données sont croissantes, lui permettant d’apprendre et d’affiner des insights avec une précision toujours améliorée. En clair, plus les données sont nombreuses, plus les ordinateurs dotés de Machine Learning sont puissants et peuvent découvrir des patterns enfouis dans ces données avec nettement plus d’efficacité que ne le ferait l’intelligence humaine.

Quelques principes clés du machine learning :

1. Apprentissage à partir de données : Le principe fondamental du machine learning est d’apprendre à partir des données plutôt que de programmer explicitement des règles ou des instructions. Les algorithmes de machine learning utilisent des données d’entraînement pour découvrir des motifs, des relations et des informations utiles.

2. Données d’entraînement : Les données d’entraînement sont essentielles pour former les modèles de machine learning. Ces données sont composées de caractéristiques (variables) et d’étiquettes (résultats attendus). Les modèles apprennent à partir de ces données pour effectuer des prédictions ou des classifications.

3. Algorithme d’apprentissage : Les algorithmes de machine learning sont des méthodes mathématiques et statistiques qui ajustent les paramètres du modèle en fonction des données d’entraînement. Il existe de nombreux types d’algorithmes, tels que les arbres de décision, les réseaux de neurones, la régression linéaire, le clustering, etc.

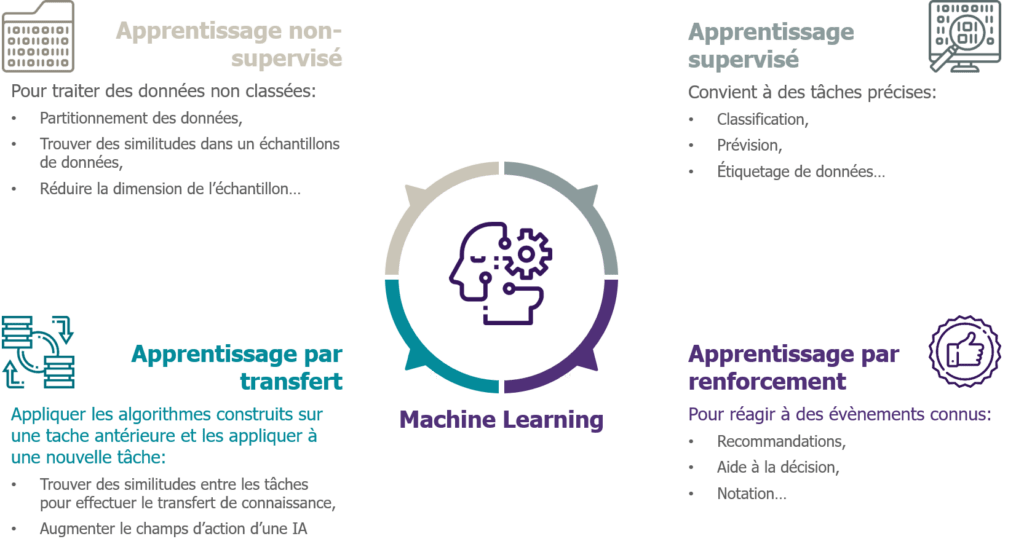

4. Apprentissage supervisé vs non supervisé : Les deux principales catégories de machine learning sont l’apprentissage supervisé et l’apprentissage non supervisé.

Apprentissage Supervisé : Le modèle est entraîné sur des données étiquetées, ce qui signifie que le modèle apprend à prédire des étiquettes à partir de caractéristiques. Par exemple, la classification d’images en « chats » ou « chiens ».

Apprentissage Non Supervisé : Le modèle explore des données non étiquetées pour découvrir des structures ou des modèles. Par exemple, la segmentation de clients en groupes de comportement similaires.

5. Évaluation et Validation : L’évaluation du modèle est essentielle pour déterminer son efficacité. Des métriques telles que la précision, le rappel, la F-mesure, et l’erreur quadratique moyenne sont utilisées pour mesurer la performance du modèle. La validation croisée (cross-validation) est couramment utilisée pour évaluer la capacité du modèle à généraliser à de nouvelles données.

6. Surapprentissage et Sous-apprentissage : Le surapprentissage se produit lorsque le modèle s’adapte trop précisément aux données d’entraînement et ne peut pas généraliser correctement. Le sous-apprentissage se produit lorsque le modèle est trop simple pour capturer des modèles complexes. L’objectif est de trouver un équilibre en ajustant les hyperparamètres du modèle.

7. Itération : L’apprentissage machine est un processus itératif. Les modèles sont entraînés, évalués, ajustés et re-entraînés pour améliorer leurs performances. Ce processus continue jusqu’à ce que le modèle atteigne la précision souhaitée.

8. Applications variées : Le machine learning est utilisé dans une multitude d’applications, y compris la classification d’images, la reconnaissance vocale, la recommandation de produits, la détection de fraude, la prédiction de prix, la médecine, la recherche, la robotique, et bien plus encore.

En résumé, le machine learning est un domaine qui repose sur l’apprentissage à partir de données pour effectuer des prédictions ou des classifications. Il existe divers types d’algorithmes de machine learning adaptés à différentes tâches et applications, et l’évaluation rigoureuse des modèles est essentielle pour garantir leur efficacité.

⭐Sans Big Data pas de Machine Learning ⚡

Le Machine Learning peut être défini comme étant « une technologie d’intelligence artificielle permettant aux machines d’apprendre sans avoir été au préalablement programmées spécifiquement à cet effet ».

Le Machine Learning est explicitement lié au Big Data, étant donné que pour apprendre et se développer, les ordinateurs ont besoin de flux de données à analyser, sur lesquelles s’entraîner.

De ce fait, le Machine Learning, issu par essence du Big Data, a précisément besoin de ce dernier pour fonctionner.

Le Machine Learning et le Big Data sont donc interdépendants.

…Allons-y plus profondément, intéressons nous à un de ses sous-domaine le « Deep Learning »

Merci, Geoffrey Hinton, Yann LeCun, et Yoshua Bengio !

Le Deep Learning, un sous domaine du Machine Learning

Le Deep Learning est une sous-discipline du machine learning qui repose sur l’utilisation de réseaux de neurones artificiels profonds pour résoudre des tâches complexes. Le principe fondamental du deep learning est d’utiliser des réseaux de neurones artificiels composés de nombreuses couches (d’où le terme « profond » ou « deep » en anglais) pour extraire des caractéristiques et apprendre des représentations hiérarchiques à partir des données.

Le deep learning permet d’approfondir l’analyse des données. Fonctionnant à l’image d’un réseau de neurones, l’information traitées par ce système est de plus en plus précise à mesure que les couches de neurones sont nombreuses. Ce type de technique plus aboutie que le machine learning convient notamment lorsque les masses de données à traiter sont immenses. En ce sens, le deep learning se différence du machine learning par le fait que cette technique accentue la précision de l’analyse et a la capacité de traiter un nombre de données plus important.

Quelques principes clés du deep learning :

1. Réseaux de Neurones Profonds : Les réseaux de neurones artificiels profonds sont composés de nombreuses couches de neurones, y compris une couche d’entrée, plusieurs couches cachées et une couche de sortie. Chaque couche effectue des transformations mathématiques sur les données d’entrée.

2. Apprentissage par Rétropropagation : L’apprentissage dans un réseau de neurones profond se fait principalement par rétropropagation de l’erreur. Le réseau est exposé à des données d’entraînement étiquetées, et l’erreur entre les prédictions du modèle et les étiquettes réelles est calculée. Ensuite, cette erreur est propagée en arrière à travers le réseau pour ajuster les poids des connexions de manière à minimiser cette erreur.

3. Représentations Hiérarchiques : Le deep learning est capable d’apprendre des représentations hiérarchiques des données. Cela signifie que chaque couche du réseau extrait des caractéristiques de plus en plus abstraites et complexes à mesure que l’on progresse dans les couches. Par exemple, dans la vision par ordinateur, les premières couches peuvent détecter des bords, tandis que les couches plus profondes peuvent identifier des motifs plus complexes, comme des visages.

4. Fonctions d’Activation : Chaque neurone d’une couche est généralement activé en fonction d’une fonction d’activation, telle que la fonction sigmoïde, la fonction ReLU (Rectified Linear Unit), ou d’autres. Ces fonctions introduisent une non-linéarité dans le modèle, ce qui permet au réseau d’apprendre des relations non linéaires dans les données.

5. Grandes Quantités de Données : Le deep learning nécessite souvent de grandes quantités de données pour être efficace, car les réseaux de neurones profonds ont un grand nombre de paramètres. Les données d’entraînement sont essentielles pour que le modèle puisse généraliser à de nouvelles données.

6. Utilisation en Vision par Ordinateur, Traitement du Langage Naturel et Plus Encore : Le deep learning a eu un impact significatif dans des domaines tels que la vision par ordinateur (reconnaissance d’images), le traitement du langage naturel (compréhension du texte), la génération de texte, la synthèse vocale, la traduction automatique, les jeux vidéo, la robotique, et bien d’autres.

7. Modèles Pré-entraînés : Il est courant de pré-entraîner des modèles de deep learning sur de grandes quantités de données, puis de les affiner pour des tâches spécifiques. Cela permet de tirer parti de la représentation hiérarchique apprise par le modèle.

Le deep learning est une approche d’apprentissage automatique qui se concentre sur l’utilisation de réseaux de neurones artificiels profonds pour extraire des caractéristiques et apprendre des représentations hiérarchiques à partir des données. Cette technologie a démontré son efficacité dans un large éventail d’applications et a considérablement amélioré les performances dans des domaines tels que la 3D, la vision par ordinateur, le traitement du langage naturel et la reconnaissance de motifs.

OK… Maintenant que l’on maîtrise un peu plus notre sujet, voyons comment l’IA, la Vision par Ordinateur et le Deep Learning vont-ils influencer la 3D 🥇

L'Intelligence Artificielle et la 3D

Le Deep Learning et la 3D

Le Deep Learning est également utilisé dans le domaine de la 3D, mais son application peut varier en fonction des besoins spécifiques du domaine.

Le Deep Learning apporte des avantages significatifs à la 3D en permettant une meilleure compréhension, modélisation et génération de données 3D. Il permet de créer des environnements virtuels plus réalistes, de faciliter la modélisation et la simulation, et d’améliorer diverses applications liées à la 3D.

Modélisation 3D : Le Deep Learning est utilisé pour la modélisation 3D, y compris la reconstruction tridimensionnelle d’objets à partir de données 2D, la génération de modèles 3D à partir de nuages de points, et la création de représentations 3D de scènes à partir d’images. Les réseaux de neurones peuvent apprendre à créer des modèles 3D réalistes à partir de données d’entrée.

Vision par Ordinateur 3D : Dans la vision par ordinateur, le Deep Learning est utilisé pour analyser des données 3D, telles que des scans 3D de scènes ou d’objets. Cela peut inclure la détection d’objets 3D, la segmentation de scènes 3D, et la compréhension d’objets dans un contexte tridimensionnel.

Génération de Contenu 3D : Le Deep Learning peut être utilisé pour générer du contenu 3D, comme des modèles d’objets, des personnages, des environnements, ou même des mondes virtuels. Les GAN (Generative Adversarial Networks) sont particulièrement adaptés à la génération de contenu 3D réaliste.

Modélisation de Surface : Les réseaux de neurones peuvent être utilisés pour modéliser des surfaces 3D, telles que des maillages 3D. Cela peut être utile dans la conception de jeux, la conception industrielle, et la simulation.

Analyse de Données 3D : Dans des domaines tels que la recherche médicale et la simulation, le Deep Learning peut être utilisé pour analyser des données 3D, telles que des images IRM ou des simulations de fluides en 3D.

Réalité Virtuelle et Augmentée : Le Deep Learning est utilisé pour améliorer l’expérience de la réalité virtuelle (VR) et augmentée (AR) en rendant les environnements 3D plus réalistes, en suivant les mouvements de l’utilisateur, et en intégrant des éléments 3D dans le monde réel.

Reconstruction de Scènes 3D : Les systèmes de Deep Learning peuvent être utilisés pour reconstruire des scènes 3D à partir de données de capteurs, comme des caméras 3D ou des lidars, dans des domaines tels que la robotique et les véhicules autonomes.

La Vision par Ordinateur et la 3D

La vision par ordinateur et la 3D sont deux domaines de l’informatique qui peuvent se compléter pour résoudre des problèmes complexes de traitement d’images et de modélisation tridimensionnelle.

La combinaison de la vision par ordinateur et de la 3D permet de créer des applications puissantes dans des domaines tels que la robotique, les jeux, la conception, la médecine, la sécurité, et bien d’autres. Elle permet de capturer, d’analyser et de comprendre des environnements tridimensionnels de manière plus précise, ce qui ouvre la voie à de nombreuses applications innovantes.

Modélisation 3D à partir d’images : La vision par ordinateur peut être utilisée pour reconstruire des modèles 3D à partir d’images 2D. Cela implique de capturer un objet ou une scène sous différents angles et d’utiliser des techniques de correspondance d’images pour créer une représentation 3D. Ces modèles 3D peuvent être utilisés dans des domaines tels que la modélisation architecturale, la réalité augmentée et la conception de jeux.

Détection d’objets 3D : Les systèmes de vision par ordinateur peuvent être adaptés pour détecter des objets en 3D dans un environnement. Cela est essentiel pour des applications telles que la conduite autonome, où les véhicules doivent détecter et suivre des objets 3D, comme les autres véhicules, les piétons et les obstacles.

Analyse de scènes tridimensionnelles : La vision par ordinateur en 3D permet d’analyser des scènes complexes et de comprendre la structure 3D d’un environnement. Cela peut être utilisé pour la surveillance de la sécurité, la navigation robotique, la réalité virtuelle et d’autres applications.

Réalité augmentée : La vision par ordinateur est au cœur des expériences de réalité augmentée (AR) où des objets virtuels doivent être intégrés dans le monde réel. La modélisation 3D de l’environnement est essentielle pour que les objets virtuels s’intègrent de manière réaliste.

Rendu 3D pour la visualisation : La vision par ordinateur peut être utilisée pour générer des images 3D à partir de modèles 3D. Ces images peuvent être utilisées pour la visualisation de données, la conception assistée par ordinateur et la simulation.

Analyse d’images médicales 3D : Dans le domaine de la médecine, la vision par ordinateur est utilisée pour analyser des images médicales en 3D, telles que les scanners CT et les IRM. Cela aide les professionnels de la santé à diagnostiquer des maladies et à planifier des interventions chirurgicales.

Reconstruction 3D à partir de vidéos : La vision par ordinateur peut être utilisée pour reconstruire des modèles 3D en mouvement à partir de séquences vidéo. Cela peut être utilisé dans la surveillance vidéo et l’analyse du mouvement.

Traitement d’images stéréo : La vision par ordinateur en 3D utilise souvent des paires d’images stéréo prises à partir de deux points de vue différents pour déterminer la profondeur des objets dans une scène. Cela est utile dans des applications telles que la cartographie 3D.

Le Deep Learning et le Bureau Virtuel 3D

Le Deep Learning et les machines virtuelles 3D avec des unités de traitement graphique (GPU) sont souvent utilisés de concert pour résoudre des problèmes complexes dans divers domaines. Voici comment ces deux technologies se combinent et interagissent :

Accélération de l’apprentissage en profondeur : Les réseaux de neurones profonds, qui sont couramment utilisés en Deep Learning, exigent des capacités de calcul importantes. Les GPU sont particulièrement bien adaptés à l’accélération des calculs nécessaires à l’apprentissage en profondeur. L’utilisation de GPU dans des machines virtuelles 3D permet d’augmenter considérablement les performances de l’apprentissage en profondeur en réduisant le temps nécessaire pour entraîner des modèles complexes.

Entraînement de modèles 3D : Dans des applications de modélisation 3D, telles que la reconstruction 3D, la génération de contenu 3D ou la détection d’objets dans des environnements tridimensionnels, les GPU accélèrent l’entraînement de modèles 3D en traitant de grandes quantités de données tridimensionnelles.

Réalité virtuelle et augmentée : Dans les applications de réalité virtuelle (VR) et augmentée (AR), les GPU sont essentiels pour rendre des environnements 3D réalistes en temps réel. Les machines virtuelles 3D avec des GPU permettent d’exécuter des simulations 3D complexes, de suivre les mouvements de l’utilisateur et de générer des environnements 3D interactifs.

Rendu 3D : Le rendu 3D, qu’il s’agisse de graphismes de jeux, de modélisation architecturale ou de visualisation scientifique, bénéficie grandement de la puissance de calcul des GPU. Les machines virtuelles 3D avec GPU permettent de créer des environnements de rendu 3D hautement performants.

Simulation et recherche scientifique : Les simulations 3D dans des domaines tels que la recherche médicale, la physique, la météorologie et l’aéronautique nécessitent des ressources de calcul importantes. Les GPU accélèrent ces simulations, et les machines virtuelles 3D offrent une plateforme flexible pour les exécuter.

Traitement d’images et de vidéos 3D : Les applications de traitement d’images et de vidéos en 3D, comme la détection d’objets dans des vidéos 3D ou la reconstruction de modèles 3D à partir de vidéos, bénéficient également de la puissance des GPU dans les machines virtuelles 3D.

Les machines virtuelles 3D avec GPU permettent de tirer parti de la puissance de calcul massivement parallèle des GPU, ce qui est essentiel pour des applications exigeantes en termes de calcul, telles que la modélisation 3D, la réalité virtuelle, le rendu 3D et l’apprentissage en profondeur.

Cela permet aux chercheurs, aux développeurs et aux professionnels de divers domaines de travailler sur des projets complexes qui nécessitent une grande capacité de traitement.

Entre la conception de la notion d'Intelligence Artificielle et sa réalisation pratique, il s'est écoulé 70 ans

💡 L’évolution de l’IA a été marquée par des avancées, des périodes de désillusion, des percées technologiques et une adoption croissante dans divers secteurs. L’IA continue de progresser et d’avoir un impact significatif sur notre société et notre façon de vivre et de travailler.

L’accélération de l’évolution de l’intelligence artificielle (IA) au cours de ces dernières années est due à plusieurs facteurs qui ont convergé pour stimuler le progrès dans ce domaine. Voici quelques-unes des raisons de cette accélération :

1. Avancées en matière de matériel : Les améliorations continues des composants matériels, notamment les GPU et les ASIC (Circuits Intégrés Spécifiques à l’Application), ont rendu les calculs nécessaires pour l’entraînement de modèles d’IA plus rapides et plus efficaces. Des entreprises telles que NVIDIA, AMD, Intel et Google ont lancé des produits spécifiquement conçus pour l’IA.

2. Augmentation de la puissance de calcul : L’utilisation de clusters de serveurs avec des milliers de GPU ou de TPU (Unités de Traitement Tensoriel) en parallèle a considérablement augmenté la puissance de calcul disponible pour les projets d’IA. Les fournisseurs de services cloud, tels qu’AWS, Microsoft Azure et Google Cloud, proposent des ressources d’IA à grande échelle.

3. Énormes quantités de données : L’IA repose en grande partie sur l’apprentissage à partir de données, et la quantité de données disponible a explosé. Les entreprises disposent de plus de données que jamais, ce qui permet d’entraîner des modèles plus précis et sophistiqués.

4. Améliorations des algorithmes : Les chercheurs en IA développent constamment de nouveaux algorithmes et améliorent les modèles existants, ce qui permet d’obtenir de meilleurs résultats. Des techniques telles que l’apprentissage profond (Deep Learning) ont révolutionné la manière dont les systèmes d’IA traitent l’information.

Revoir – Partie 1 – L’Intelligence Artificielle, les différentes approches et types

Ça vous a plus ?

Partager cet l’Article

Pour aller plus loin 🔝 lisez notre article sur

la Carte Graphique et son fameux GPU – le Bureau Virtuel l’outil ultime – La Réalité Augmentée, réagir avec son environnement

Quelle est l’offre de VIRTUAL SR en la matière ?

Les Applications d’IA, en particulier celles basées sur l’apprentissage profond, nécessitent d’énormes quantités de calculs pour traiter et analyser des données. Ces besoins en calculs peuvent rapidement devenir prohibitifs pour les processeurs CPU traditionnels.

L’Utilisation de machines virtuelles avec GPU, en particulier à haute performance, sont devenus incontournables pour répondre aux besoins de calculs intensifs de l’IA. Les GPU sont conçus pour effectuer un grand nombre de calculs en parallèle, ce qui les rend idéaux pour les tâches d’apprentissage automatique, d’entraînement de réseaux de neurones, de vision par ordinateur, et bien d’autres.

L’IA nécessite d’importantes capacités de calcul, et les machines virtuelles avec GPU sont un moyen efficace et flexible de satisfaire ces besoins, en particulier lorsque la puissance de calcul peut être adaptée en fonction des besoins de manière évolutive. Cela permet aux développeurs et aux chercheurs d’accéder à des ressources de calcul de pointe pour l’entraînement de modèles d’IA sans avoir à investir dans un matériel coûteux.

Notre objectif vise à vous faire exploiter la puissance de notre plateforme et de nos bureaux virtuels 3D pour améliorer la création, le développement et l’utilisation d’applications d’IA, tout en offrant des avantages de flexibilité considérables.

L’utilisation d’une architecture virtuelle personnalisée en cloud, avec des bureaux virtuels 3D haute performance offre de nombreuses opportunités pour améliorer la création, le développement et l’utilisation de votre IA.

✅ Les avantages de passer à la solution VIRTUAL SR :

L’utilisation d’une infrastructure performante et de bureaux virtuels 3D dans le domaine de l’IA permet d’améliorer l’efficacité, la flexibilité, la sécurité et l’évolutivité, tout en facilitant la collaboration.

Puissance de Calcul : L’IA nécessite souvent une puissance de calcul considérable pour l’entraînement de modèles, la simulation et d’autres tâches. Une infrastructure performante, dotée de GPU (unités de traitement graphique) de pointe, peut accélérer ces opérations, réduisant ainsi le temps nécessaire pour accomplir des tâches complexes.

Parallélisme : Les GPU sont conçus pour effectuer des calculs en parallèle, ce qui est essentiel pour l’apprentissage en profondeur et d’autres tâches liées à l’IA. Une infrastructure performante équipée de GPU permet de réaliser des calculs massivement parallèles, améliorant ainsi l’efficacité et les performances.

Flexibilité : Les bureaux virtuels 3D permettent aux utilisateurs d’accéder à des environnements de travail virtuels hautement performants depuis n’importe quel endroit, sur n’importe quel appareil. Cela offre une grande flexibilité pour les professionnels de l’IA qui peuvent travailler à distance ou sur le terrain, tout en profitant d’une puissance de calcul élevée.

Collaboration : Les bureaux virtuels 3D facilitent la collaboration en permettant à plusieurs utilisateurs d’accéder simultanément à un même environnement de travail 3D, ce qui est utile pour la collaboration sur des projets d’IA complexes.

Sécurité : Les bureaux virtuels 3D offrent un niveau élevé de sécurité, car les données et les applications restent sur les serveurs centralisés, réduisant ainsi les risques de perte de données ou de compromission de la sécurité. Cela est particulièrement important lorsque l’on travaille avec des données sensibles dans le domaine de l’IA.

Évolutivité : Une infrastructure performante peut être facilement mise à l’échelle pour répondre aux besoins changeants en matière de calcul. Lorsque les besoins en puissance de calcul augmentent, il est possible d’ajouter rapidement des ressources supplémentaires, ce qui est essentiel pour des projets d’IA à grande échelle.

Réduction des coûts : Les bureaux virtuels 3D permettent de réduire les coûts liés à la maintenance des postes de travail physiques, car la gestion des logiciels, des mises à jour et de la sécurité est centralisée. De plus, l’utilisation d’une infrastructure performante peut permettre de réduire le temps nécessaire pour accomplir des tâches, ce qui peut se traduire par des économies de coûts.

Accessibilité : Les bureaux virtuels 3D permettent aux professionnels de l’IA d’accéder aux ressources de calcul hautement performantes même s’ils ne disposent pas d’un matériel informatique de pointe. Cela élargit l’accès à ces technologies.

Expérience utilisateur améliorée : Les bureaux virtuels 3D offrent une expérience utilisateur fluide en permettant l’utilisation d’applications gourmandes en ressources, telles que des logiciels de modélisation 3D, de simulation ou d’analyse de données, sans ralentissement ni latence.